Сколько памяти нужно видеокарте?

С чего вообще начались споры об объеме VRAM?

2023 год подкинул много поводов призадуматься. Если раньше фейлы c оптимизацией условного Arkham Knight и Fallout 76 происходили не так уж часто и вызывали много споров, то в 2023 году проблема стала носить системный характер. Все началось буквально в январе с Forspokoen, когда оказалось, что для нового ААА-проекта Square Enix про попаданца в фентези-мир банально не хватает 8 ГБ видеопамяти, чтобы нормально поиграть. По словам Алекса Баттальи из Digital Foundry, он за 2 недели тестов так не смог найти оптимальные настройки графики для видеокарт, у которых менее 8 ГБ VRAM. А это большая часть ПК-игроков, если верить статистике Steam.

В той или иной степени история повторилась с релизами Redfall, Gotham Knights и недавней Starfield, которые ни по одному параметру не подходят под определение «некст-ген», но при этом предъявляют неадекватные требования к видеокарте и объему VRAM. У многих других геймеров накопилось много вопросов к играм последних лет. Почему тот же Cyberpunk 2077 выглядит лучше большинства игр, вышедших спустя 3 года и ему хватает 8 ГБ? Где фотореалистичная графика в Forspoken? Почему Gotham Knights 2023 года выглядит хуже, чем Batman: Arkham Knight 8-летней давности и при этом умудряется тормозить даже на топовых RTX 4080 и 4090?

Что такое VRAM и за что она отвечает

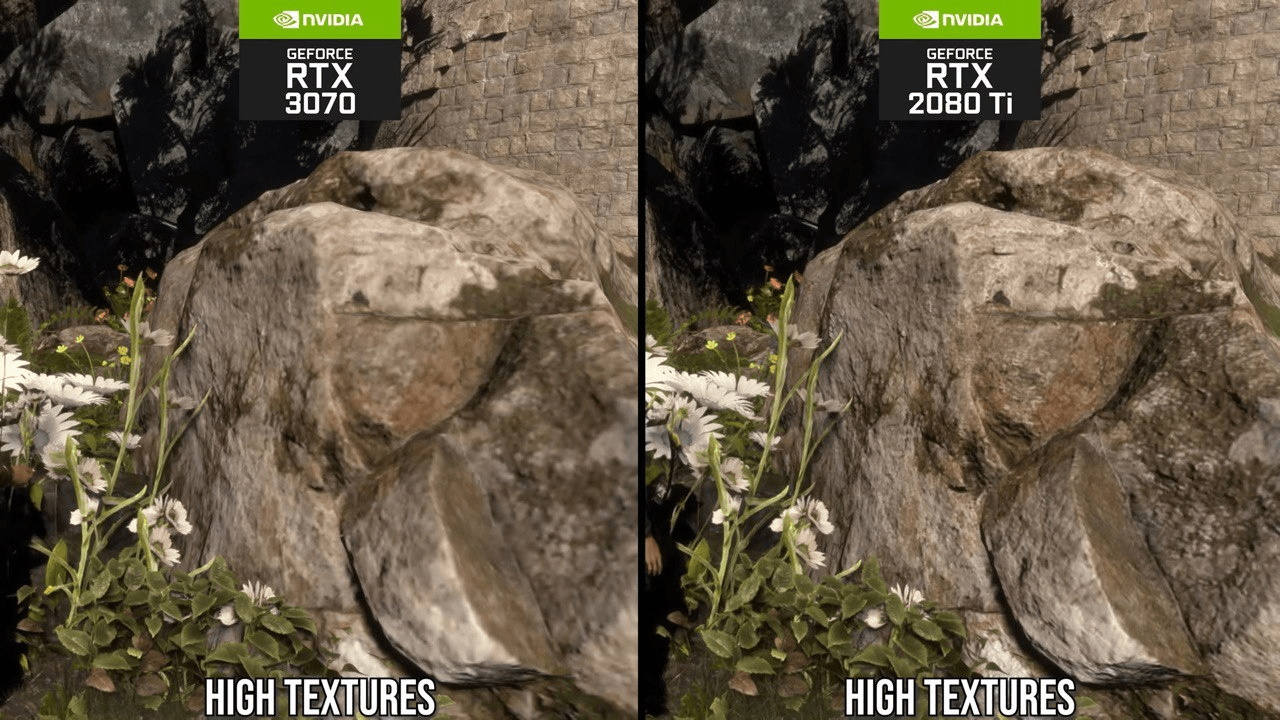

|

| Из-за нехватки 8 ГБ памяти, RTX 3070 не смогла загрузить все текстуры, как и менее слабая RTX 2080 Ti с 11 ГБ VRAM. |

Если сильно упростить, то VRAM ― это специализированная память, играющая роль своеобразного буфера, в котором хранятся текстуры, шейдеры, полигоны и другие важные для игры видеоданные, которые впоследствии отображаются на экране. Нехватка видеопамяти может оказать разнообразное воздействие на игровой опыт. Её влияние проявляется в нескольких ключевых аспектах.

Низкая производительность и «слайдшоу»: Когда видеокарта не имеет достаточно видеопамяти для хранения всех необходимых текстур и данных, это может привести к резкому снижению производительности. Игра становится неиграбельной, и вы видите крайне низкий FPS, что делает игровой процесс практически невозможным. Это самый очевидный вариант.

Статтеры и рваный фреймтайм: в случае нехватки видеопамяти, изображение в игре может начинать неприятно дергаться, особенно если в кадре много сложных для обработки объектов, а игрок постоянно крутится. К примеру в недавнем God Of War для ПК на старых карточках Radeon c 4 ГБ игра в большинстве случаев выдавала стабильные 60 FPS (прим: в Full HD и средних настройках), однако ситуация заметно портилась, как только дело доходило до боя. При этом счетчик FPS мог визуально показывать 45 – 50 FPS, но из-за плохого фреймтайма картинка выглядела дерганной.

Сниженное качество текстур: когда видеопамяти мало, игра может динамически снижать качество текстур для оптимизации. К примеру, они могут начать загружаться прямо перед вашими глазами (привет, люди-картошки в Cyberpunk 2077). Либо загрузиться в низком разрешении. Либо начать мерцать.

Тесты: 8 ГБ против 16 ГБ в играх 2023 года

|

| Radeon RX 6800 против GeForce RTX 3070. |

Объем видеопамяти (VRAM), который считается нормой для игр, сильно зависит от требований конкретных игр и разрешения экрана. Так, если вы играете только в нетребовательные компьютерные игры (половина из которых — это сетевые приложения, в которых графика — не главное), то смысла задумываться об этом нет вообще. Здесь надо ориентироваться на FPS, который может обеспечить тот или иной 3D-ускоритель. К примеру, для условной Доты или CS: GO хватит обычной интегрированной видеокарты а-ля Radeon Vega или Intel Iris, у которых фактически нет VRAM. Вместо нее они используют так называемую «shared memory», которую заимствуют из оперативной памяти. Другое дело, если вы планируете играть в новейшие ресурсоемкие проекты хотя бы с использованием высоких настроек качества графики.

Интересным примером влияния видеопамяти на производительность видеокарты стал нашумевший тест популярной GeForce RTX 3070 против куда менее раскрученной Radeon RX 6800. На момент выхода в 2021 году обе карточки стоили практически одинаково и выдавали практически идентичные результаты. В большинстве тестов разрыв в FPS не превышал 8%, а вся разница заключалась лишь в объеме памяти: AMD/Radeon расщедрились на 16 ГБ видеопамяти, в то время как NVIDIA ограничилась 8 ГБ. За что, к слову, некоторые специалисты ругали NVIDIA еще во время анонса.

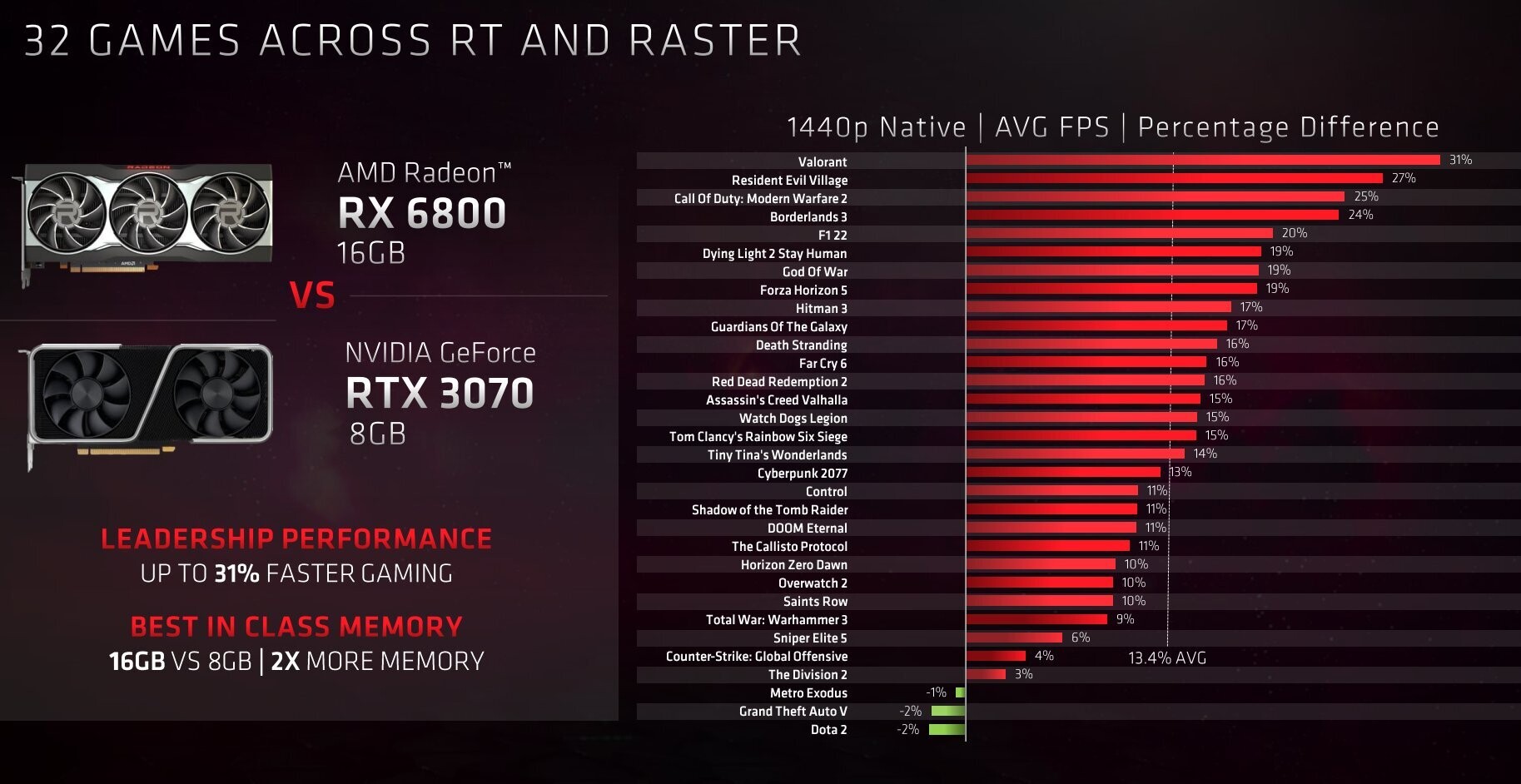

|

| Официальное сравнение Radeon RX 6800 и GeForce RTX 3070 от AMD. |

Спустя 2 года критики оказались на 100% правы и теперь это видеоускорители разной ценовой категории. В недавно портированной на ПК первой части The Last of Us детище Radeon опередила конкурента почти в полтора раза. В Hogwarts Legacy при разрешении 1440p разница в производительности между RX 6800 и RTX 3070 в FPS оказалась чуть ли не двукратной. И это после масштабного патча, который починил производительность. До него RTX 3070 была практически не играбельна.

А дальше все еще интереснее. В тестах The Callisto Protocol и в Full HD, и в 2K разрешении обе карточки идут плюс-минус вровень. Пока вы не включите рейтрейсинг, после чего у GeForce RTX 3070 подкашиваются ноги и она выдает в среднем 10 FPS. С просадками до 4 FPS. Как в это вообще играть? В то же время Radeon RX 6800 с ее 16 ГБ гарантирует в среднем 56 FPS, не опускаясь ниже 38 FPS в особо загруженных сценах. И это ситуация повторяется в A Plague Tale: Requiem, Resident Evil 4, Marvel’s Spider-Man: Miles Morales и пачке других игр, в которых видеокарта от NVIDIA по идее должна была быть первой за счет аппаратных RT-ядер.

Что тут говорить, если даже Doom Eternal 2020 года выпуска в 2K и с настройками Ultra Nightmare ставил на колени любую мало-мальски мощную видеокарту с 8 ГБ VRAM. К примеру, та же RTX 3070 с такими настройками задыхается, едва выдавая в среднем 26 FPS, в то время как Radeon RX 6800 даже не успевает вспотеть со своими почти 100 FPS. Разница почти в 5 раз, Карл! (простите)

Так почему выросли требования современных игр?

|

| Тот самый фотореалистичный камень в истории игр из Forspoken. |

Ответ на вопрос, почему так сильно выросли требования по памяти, с одной стороны связан с распространением 2K и 4K мониторов, с другой причина кроется в снизившихся стандартах качества и лени многих разработчиков ААА-игр. В старых играх, которые по меркам своего времени считались красивыми и реалистичными, часто шли на разнообразные хитрости, чтобы повысить быстродействие движка. К примеру, у камней могло быть всего несколько разных текстур, которые по сути постоянно повторялись. А сейчас Тодд Говард просто говорит вам «наша игра отлично оптимизирована, это вам пора обновить компьютер».

А если серьезно, то современные высокобюджетные игры повально стремятся к фотореализму, на банальный камень, лежащий посреди леса, разработчики могут натянуть несколько разных высококачественных текстур, чтобы придать ему уникальный вид. А при создании фотореалистичных пейзажей разработчики стремятся использовать 4K/8K текстуры, которые будут выглядеть натурально, даже когда игрок упадет лицом на этот самый камень. Для лучшего понимания масштабов, раньше игровая текстура могла состоять из 5000 полигонов, в новом Unreal Engine 5 с его системой рендеринга Nanite нормой стала цифра от 500 тысяч до 2 миллионов полигонов.

|

| Из-за перегрузки Texture Streaming Pool полигоны этой стены попросту не загрузились, напоминая графику Minecraft или олдскульных игр конца 90-х. |

Геометрия объектов нынче также требует существенно больше VRAM, чем раньше. Допустим, есть у нас кирпичная стена и вот когда ты смотришь на нее сбоку, то хочется чтобы было видно, как выпирают кирпичи и что это не просто плоская стена с текстурой кирпичей. К примеру, в Unreal Engine 5 процесс генерации текстур частично лежит на самом движке, что с одной стороны упрощает работу с ним, с другой повышает требования к объему видеопамяти. Если ее мало и буфер Texture Streaming Pool переполняется, то текстуры просто перестают подгружаться из-за чего любой объект становится похож на низкополигонное нечто с незагруженными текстурами.

Выросли требования и к созданию персонажей. К примеру, в старых играх на манер GTA 3 Vice City на фигурку Тони фактически натягивали одну единственную текстуру со штанами, гавайской рубахой и кедами. Сравните это с условным Baldur’s Gate 3 или The Callisto Protocol с реалистичными лицами персонажей, натуралистичными волосами и лицевой анимацией почти как в жизни.

Так сколько видеопамяти нужно в 2023 году?

|

| Влияние видеопамяти в тестах видеокарт Radeon. |

Как объяснял один из разработчиков Unreal Engine 5 ситуация с видеопамятью в будущем только усугубится. Главная причина ― это тот самый некстген, которого мы до сих пор в глаза не видели. Многие крупные компании заточены под разработку игр для консолей PlayStation 5 и Xbox Series X с их 12 ГБ видеопамяти, аппаратной декомпрессией и стримингом с SSD. Многим разработчикам будет крайне сложно перестроиться после PS5 на 8 ГБ VRAM, пытаясь оптимизировать картинку для ПК без видимой потери качества. Кому-то на это может банально не хватить времени, так как разработка игр нынче стоит дорого. Плюс многие компании вроде CD Projekt Red переходят на прогрессивный Unreal Engine 5 с его HD-текстурами, мешами, нанитами и глобальным освещением Lumen. И как показали первые проекты на UE5 все эти прелести стоят немалых ресурсов.

Даже если вы не планируете сильно завышать разрешение, налегать на рейтрейсинг и играть исключительно на «ультре», самым разумным и оптимальным вариантом с заделом на будущее станет видеокарта с 16 ГБ видеопамяти. В упоминавшихся выше Forspoken и Hogwarts Legacy 12 ГБ были необходимым минимумом для связки «Full HD + Ультра». А Resident Evil 4 Remake в «Full HD + Ультра» на некоторых системах с 8 ГБ VRAM вообще не запускался и постоянно вылетал. Поэтому 8 ГБ, которые еще недавно были нормой, в ближайшее время могут стать бесперспективным вариантом и сулят регулярные тормоза с зависаниями и вылетами, помноженные на поиск оптимальных графических настроек.

Что касается выбора конкретной модели, то на наш взгляд правильнее было бы поискать по выгодным ценам старичков двух- или трехлетней давности: у NVIDIA это могут быть модифицированные RTX 2060 и RTX 3060 с 12 ГБ памяти или RTX 2080 Ti с 11 ГБ, у Radeon ― упоминавшаяся выше RX 6800, а также младшие RX 6700 XT и 6750 XT.

Cтатьи, обзоры, полезные советы

Все материалы