Скільки пам'яті потрібно відеокарті?

З чого взагалі почалися суперечки про об'єм VRAM?

2023 підкинув багато приводів замислитися. Якщо раніше фейли з оптимізацією умовного Arkham Knight і Fallout 76 відбувалися не так часто і викликали багато суперечок, то в 2023 році проблема стала мати системний характер. Все почалося буквально в січні з Forspoken, коли виявилося, що для нового ААА-проєкту Square Enix про попаданця у фентезі-світ банально не вистачає 8 ГБ відеопам'яті, щоби нормально пограти. За словами Алекса Батальї з Digital Foundry, він за 2 тижні тестів так і не зміг знайти оптимальні налаштування графіки для відеокарт, у яких менше 8 ГБ VRAM. А це більшість ПК-гравців, якщо вірити статистиці Steam.

Тією чи іншою мірою історія повторилася з релізами Redfall, Gotham Knights і недавньої Starfield, які за жодним параметром не підходять під визначення «некст-ген», але при цьому висувають неадекватні вимоги до відеокарти та об'єму VRAM. У багатьох інших геймерів накопичилося багато питань до ігор останніх років. Чому той же Cyberpunk 2077 виглядає краще за більшість ігор, що вийшли через 3 роки і йому вистачає 8 ГБ? Де фотореалістична графіка у Forspoken? Чому Gotham Knights 2023 виглядає гірше, ніж Batman: Arkham Knight 8-річної давності і при цьому примудряється гальмувати навіть на топових RTX 4080 і 4090?

Що таке VRAM і за що вона відповідає

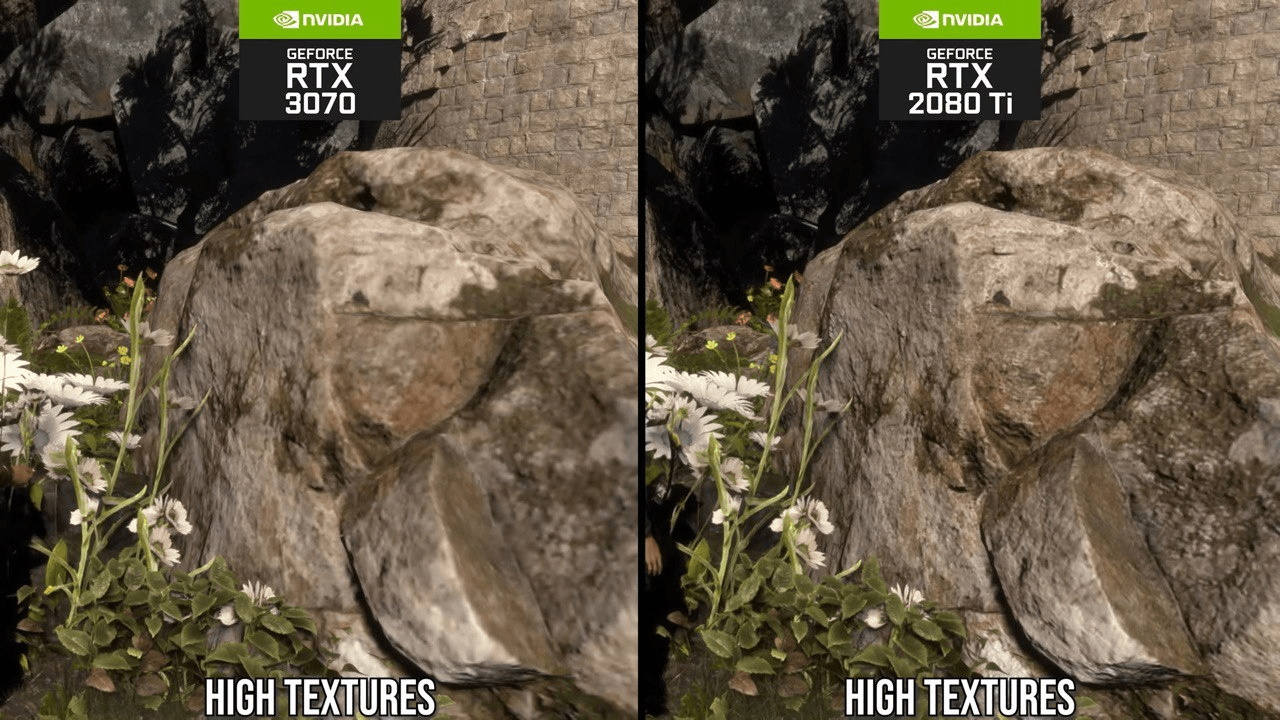

|

| Через нестачу 8 ГБ пам'яті RTX 3070 не змогла завантажити всі текстури, як і менш слабка RTX 2080 Ti з 11 ГБ VRAM. |

Якщо сильно спростити, то VRAM – це спеціалізована пам'ять, що грає роль своєрідного буфера, в якому зберігаються текстури, шейдери, полігони та інші важливі для гри відеодані, які згодом відображаються на екрані. Нестача відеопам'яті може мати різноманітний вплив на ігровий досвід. Її вплив проявляється у кількох ключових аспектах.

Низька продуктивність та «слайдшоу»: Коли відеокарта не має достатньої пам'яті для зберігання всіх необхідних текстур і даних, це може призвести до різкого зниження продуктивності. Гра стає неграбельною, і ви бачите вкрай низький FPS, що робить ігровий процес практично неможливим. Це найочевидніший варіант.

Статери та рваний фреймтайм: у разі нестачі відеопам'яті зображення в грі може починати неприємно смикатися, особливо якщо в кадрі багато складних для обробки об'єктів, а гравець постійно крутиться. Наприклад, у недавньому God Of War для ПК на старих картках Radeon c 4 ГБ гра в більшості випадків видавала стабільні 60 FPS (прим: у Full HD і середніх налаштуваннях), проте ситуація помітно псувалася, як тільки справа доходила до бою. При цьому лічильник FPS міг візуально показувати 45 – 50 FPS, але через поганий фреймтайм картинка виглядала такою, що смикається.

Знижена якість текстур: коли відеопам'яті замало, гра може динамічно знижувати якість текстур для оптимізації. Наприклад, вони можуть почати завантажуватися перед вашими очима (привіт, люди-картоплі в Cyberpunk 2077). Або завантажитись у низькій роздільній здатності. Або почати мерехтіти.

Тести: 8 ГБ проти 16 ГБ в іграх 2023 року

|

| Radeon RX 6800 проти GeForce RTX 3070 |

Об'єм відеопам'яті (VRAM), який вважається нормою для ігор, залежить від вимог конкретних ігор і роздільної здатності екрану. Так, якщо ви граєте тільки в невибагливі комп'ютерні ігри (половина з яких – це мережеві додатки, в яких графіка не головне), то сенсу замислюватися про це немає взагалі. Тут треба орієнтуватися на FPS, який може забезпечити той чи інший 3D-прискорювач. Наприклад, для умовної Доти або CS:GO вистачить звичайної інтегрованої відеокарти а-ля Radeon Vega або Intel Iris, у яких практично немає VRAM. Замість неї вони використовують так звану shared memory, яку запозичують з оперативної пам'яті. Інша справа, якщо ви плануєте грати в нові ресурсомісткі проєкти хоча б з використанням високих налаштувань якості графіки.

Цікавим прикладом впливу відеопам'яті на продуктивність відеокарти став тест популярної GeForce RTX 3070 проти менш розкрученої Radeon RX 6800. На момент виходу в 2021 році обидві картки коштували практично однаково і видавали практично ідентичні результати. У більшості тестів розрив у FPS не перевищував 8%, а вся різниця полягала лише в об'ємі пам'яті: AMD/Radeon розщедрилися на 16 ГБ відеопам'яті, тоді як NVIDIA обмежилася 8 ГБ. За що, до речі, деякі фахівці критикували NVIDIA ще під час анонсу.

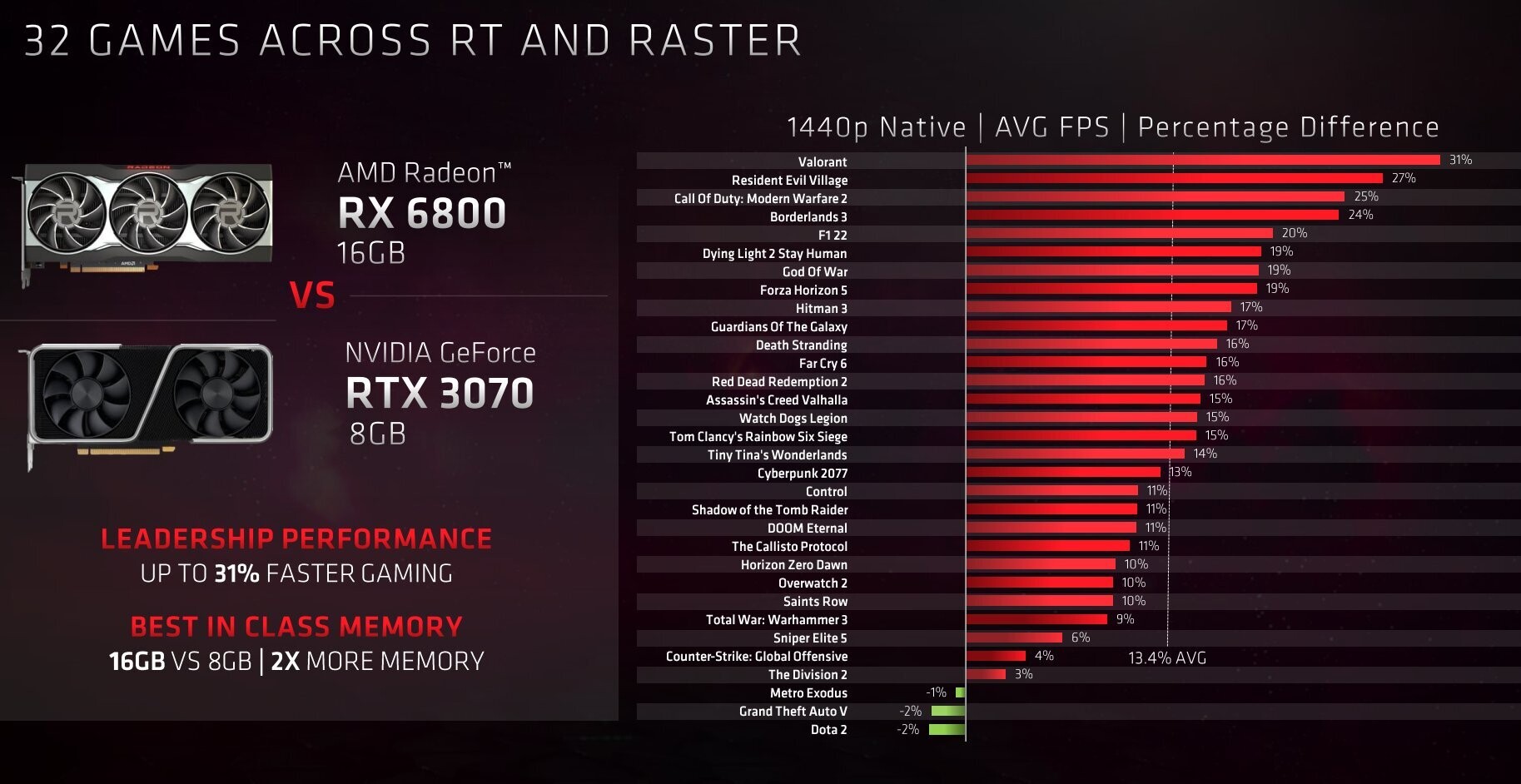

|

| Офіційне порівняння Radeon RX 6800 та GeForce RTX 3070 від AMD. |

Через 2 роки критики виявилися на 100% правими і тепер це відеоприскорювачі різної цінової категорії. У нещодавно портованій на ПК першій частині The Last of Us дітище Radeon випередила конкурента майже у півтора рази. У Hogwarts Legacy при роздільній здатності 1440p різниця у продуктивності між RX 6800 і RTX 3070 у FPS виявилася чи не дворазовою. І це після масштабного патчу, який полагодив продуктивність. До нього RTX 3070 була практично не грабельною.

А далі все ще цікавіше. У тестах The Callisto Protocol і в Full HD, і в роздільній здатності 2K обидві картки йдуть плюс-мінус врівень. Поки ви не ввімкнете рейтрейсинг, після чого у GeForce RTX 3070 ноги підкошуються і вона видає в середньому 10 FPS. З просіданням до 4 FPS. Як у це взагалі грати? У той же час, Radeon RX 6800 з її 16 ГБ гарантує в середньому 56 FPS, не опускаючись нижче 38 FPS в особливо завантажених сценах. І ця ситуація повторюється в A Plague Tale: Requiem, Resident Evil 4, Marvel's Spider-Man: Miles Morales та пачці інших ігор, у яких відеокарта від NVIDIA мала бути першою за рахунок апаратних RT-ядер.

Що тут говорити, якщо навіть Doom Eternal 2020 року випуску в 2K і з налаштуваннями Ultra Nightmare ставив на коліна будь-яку більш-менш потужну відеокарту з 8 ГБ VRAM. Приміром, та ж RTX 3070 з такими налаштуваннями задихається, ледве видаючи в середньому 26 FPS, тоді як Radeon RX 6800 навіть не встигає спітніти зі своїми майже 100 FPS. Різниця майже в 5 разів, Карле! (вибачте)

То чому виросли вимоги сучасних ігор?

|

| Той самий фотореалістичний камінь в історії ігор з Forspoken. |

Відповідь на питання, чому так сильно зросли вимоги щодо пам'яті, з одного боку пов'язаний з поширенням 2K і 4K моніторів, з іншого причина криється в стандартах якості, що знизилися, і ліні багатьох розробників ААА-ігор. У старих іграх, які за мірками свого часу вважалися красивими та реалістичними, часто йшли на різноманітні хитрощі, щоб підвищити швидкодію двигуна. Наприклад, у каміння могло бути лише кілька різних текстур, які насправді завжди повторювалися. А зараз Тодд Говард просто каже вам «наша гра відмінно оптимізована, це вам настав час оновити комп'ютер».

А якщо серйозно, то сучасні високобюджетні ігри повально прагнуть фотореалізму, на банальний камінь, що лежить посеред лісу, розробники можуть натягнути кілька різних високоякісних текстур, щоб надати йому унікального вигляду. А при створенні фотореалістичних пейзажів розробники прагнуть використовувати 4K/8K текстури, які виглядатимуть натурально, навіть коли гравець впаде обличчям на цей камінь. Для кращого розуміння масштабів раніше ігрова текстура могла складатися з 5000 полігонів, у новому Unreal Engine 5 з його системою рендерингу Nanite нормою стала цифра від 500 тисяч до 2 мільйонів полігонів.

|

| Через перевантаження Texture Streaming Pool полігони цієї стіни просто не завантажилися, нагадуючи графіку Minecraft або олдскульних ігор кінця 90-х. |

Геометрія об'єктів нині також потребує значно більше VRAM, ніж раніше. Припустимо, є у нас цегляна стіна і ось коли ти дивишся на неї збоку, то хочеться, щоб було видно, як випирають цеглини і що це не просто плоска стіна з текстурою цегли. Наприклад, в Unreal Engine 5 процес генерації текстур частково лежить на самому движку, що з одного боку полегшує роботу з ним, з іншого підвищує вимоги до об'єму відеопам'яті. Якщо її мало і буфер Texture Streaming Pool переповнюється, то текстури просто перестають підвантажуватися, через що будь-який об'єкт стає схожим на низькополігонне щось із незавантаженими текстурами.

Виросли вимоги до створення персонажів. Наприклад, у старих іграх на кшталт GTA 3 Vice City на фігурку Тоні фактично натягували одну єдину текстуру зі штанами, гавайською сорочкою та кедами. Порівняйте це з умовним Baldur's Gate 3 або The Callisto Protocol з реалістичними обличчями персонажів, натуралістичним волоссям та лицьовою анімацією майже як у житті.

То скільки відеопам'яті потрібно у 2023 році?

|

| Вплив відеопам'яті у тестах відеокарт Radeon. |

Як пояснював один з розробників Unreal Engine 5, ситуація з відеопам'яттю в майбутньому тільки посилиться. Головна причина – це той самий некстген, якого ми досі не бачили в очі. Багато великих компаній заточено під розробку ігор для консолей PlayStation 5 і Xbox Series X з їх 12 ГБ відеопам'яті, апаратною декомпресією та стрімінгом з SSD. Багатьом розробникам буде надто складно перебудуватися після PS5 на 8 ГБ VRAM, намагаючись оптимізувати картинку для ПК без видимої втрати якості. Комусь на це може банально не вистачити часу, оскільки розробка ігор нині коштує дорого. Плюс багато компаній на кшталт CD Projekt Red переходять на прогресивний Unreal Engine 5 з його HD-текстурами, мешами, нанітами та глобальним освітленням Lumen. І як показали перші проєкти на UE5 всі ці принади коштують чималих ресурсів.

Навіть якщо ви не плануєте сильно завищувати роздільну здатність, налягати на рейтрейсинг і грати виключно на «ультрі», найрозумнішим та найоптимальнішим варіантом із заділом на майбутнє стане відеокарта з 16 ГБ відеопам'яті. У згадуваних вище Forspoken і Hogwarts Legacy 12 ГБ були необхідним мінімумом для зв'язки «Full HD + Ультра». А Resident Evil 4 Remake в «Full HD + Ультра» на деяких системах з 8 ГБ VRAM взагалі не запускався і постійно вилітав. Тому 8 ГБ, які ще недавно були нормою, найближчим часом можуть стати безперспективним варіантом і обіцяють регулярні гальма із зависаннями та вильотами, помножені на пошук оптимальних графічних налаштувань.

Що стосується вибору конкретної моделі, то на наш погляд правильніше було б пошукати за вигідними цінами старі моделі двох-або трирічної давності: у NVIDIA це можуть бути модифіковані RTX 2060 та RTX 3060 з 12 ГБ пам'яті або RTX 2080 Ti з 11 ГБ, у Radeon ― згадувана вище RX 6800, а також молодші RX 6700 XT та 6750 XT.

Статті, огляди, корисні поради

Усі матеріали